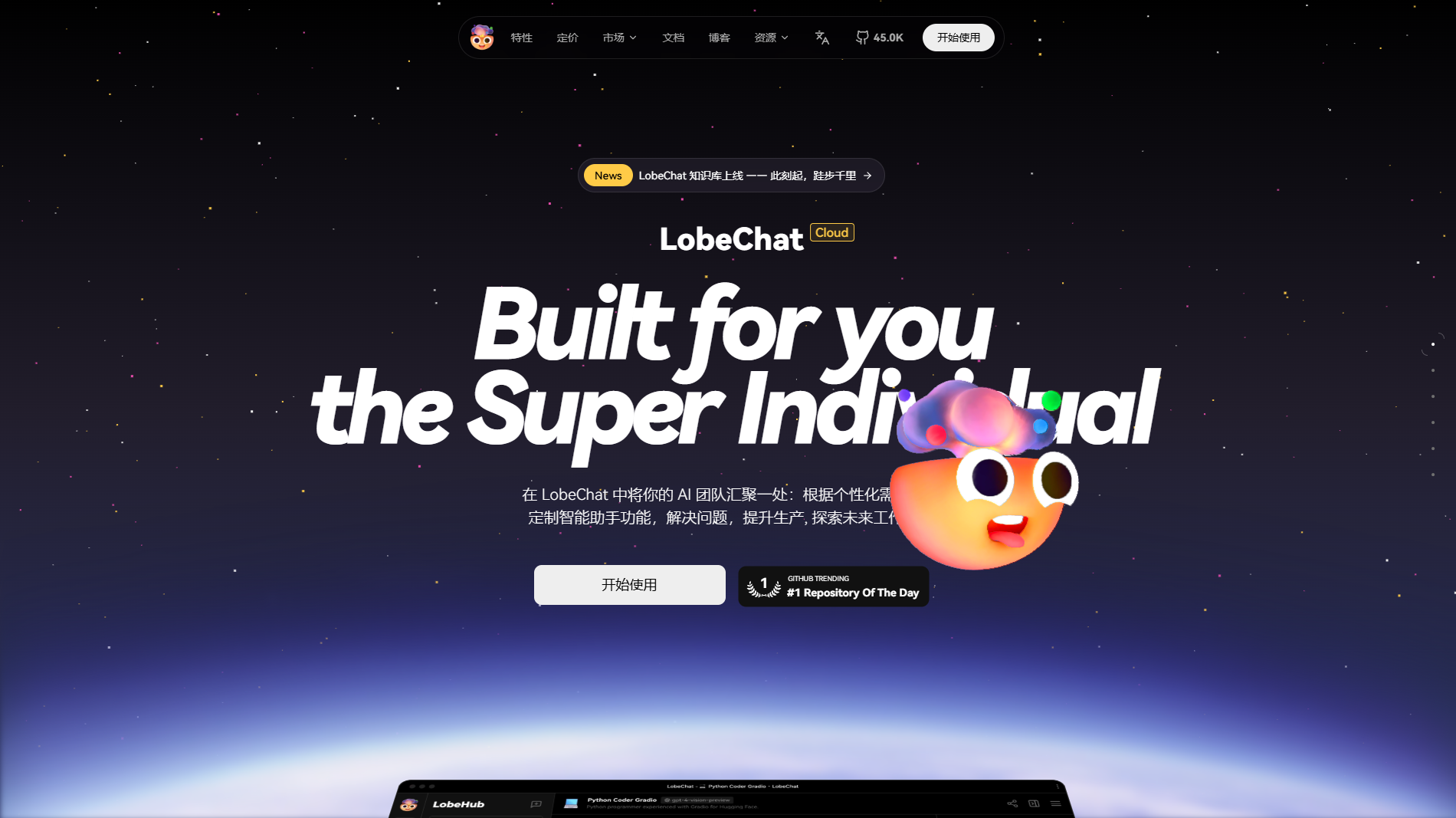

LobeChat 是一个开源的、可自定义的 AI 聊天机器人框架,旨在帮助开发者快速搭建基于大语言模型的对话式 AI 应用。该项目以模块化设计为核心,支持灵活扩展和部署,为企业与个人开发者提供高效的工具,特别适合有多语言支持、多模型集成需求的项目。

一、项目核心功能

- 支持多种模型集成

- 可无缝集成多个 AI 模型(如 OpenAI 的 GPT 系列、Llama、Claude 等),根据需求切换或混合使用。

- 多语言支持

- 天然支持多语言对话,尤其在跨地区、多语种的项目中具备优势。

- 模块化架构

- 通过插件和扩展模块轻松添加新功能,例如定制化的对话流、特定领域的知识库支持等。

- 低门槛部署

- 提供 Docker 容器化支持,帮助开发者快速在本地或云端环境部署。

- 数据隐私友好

- 允许本地化部署,确保数据控制权掌握在用户手中,满足隐私敏感场景需求。

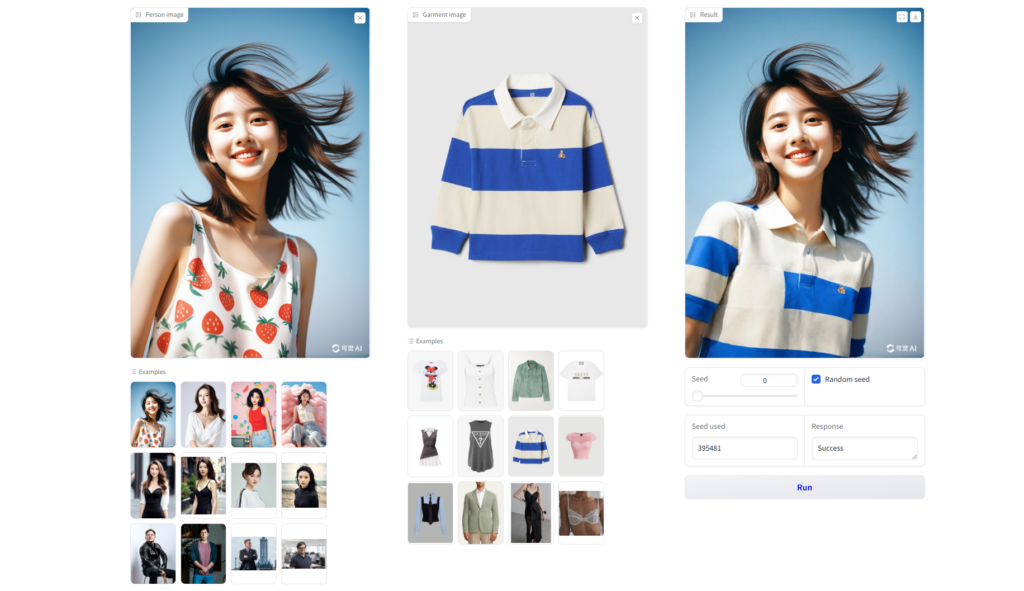

![图片[1]-LobeChat 开源项目:探索开源 AI 聊天机器人平台-|Ai Maker Hub|](https://aimakerhub.com/wp-content/uploads/2024/11/122112221-1024x575.png)

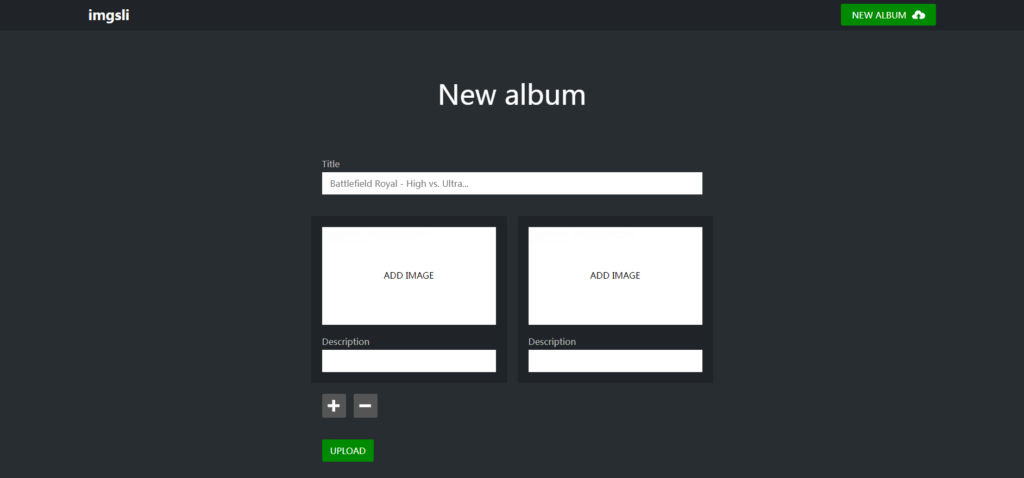

三、快速上手指南

1. 环境准备

- 系统需求:

- 推荐使用 Linux 或 MacOS 环境,Windows 环境需确保支持 Docker。

- 依赖工具:

- Git

- Docker 和 Docker Compose

- Python(如需要本地调试代码)

2. 项目克隆与启动

- 克隆项目代码bash复制代码

git clone https://github.com/lobechat/lobechat.git cd lobechat- 启动 Docker 容器

- 进入项目目录,运行以下命令:bash复制代码

docker-compose up -d- 等待部署完成后,通过浏览器访问

http://localhost:3000进入 LobeChat 界面。

3. 配置模型与 API

- 打开配置文件

config.json或通过 Web UI 设置:- 填入 OpenAI 或其他模型的 API 密钥。

- 根据需要选择并配置默认模型(如 GPT-4、Llama 2)。

4. 自定义插件开发(可选)

- 创建插件目录并定义新功能模块:

- 编写 Python 或 Node.js 脚本,根据需求处理输入输出数据。

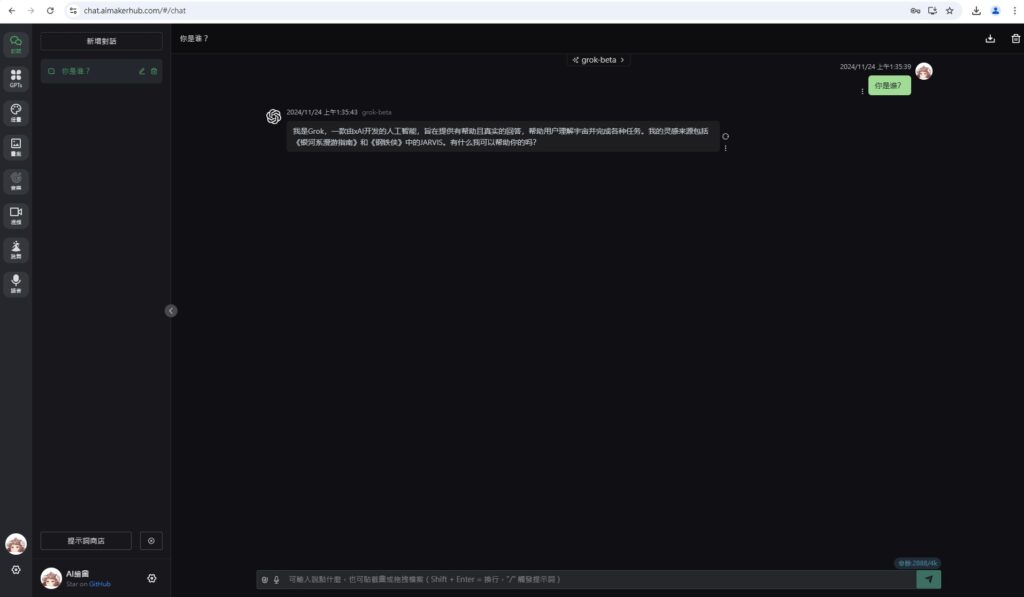

![图片[2]-LobeChat 开源项目:探索开源 AI 聊天机器人平台-|Ai Maker Hub|](https://aimakerhub.com/wp-content/uploads/2024/11/2323322-1024x577.png)

四、项目优势

- 完全开源

- 代码托管在 GitHub 上,允许开发者根据项目需求自由修改与二次开发。

- 强大的社区支持

- 开发者社区提供丰富的文档和教程,新手也能快速上手。

- 可扩展性强

- 模块化设计让开发者能轻松定制或增加新功能,避免复杂的代码耦合问题。

五、相关资源与链接

- 官方网站

- GitHub 仓库

- 文档与教程

- 官方 Wiki 提供详细的安装、配置与插件开发指南。

- 社区与支持

- 加入官方 Discord 或论坛,参与讨论和问题反馈。

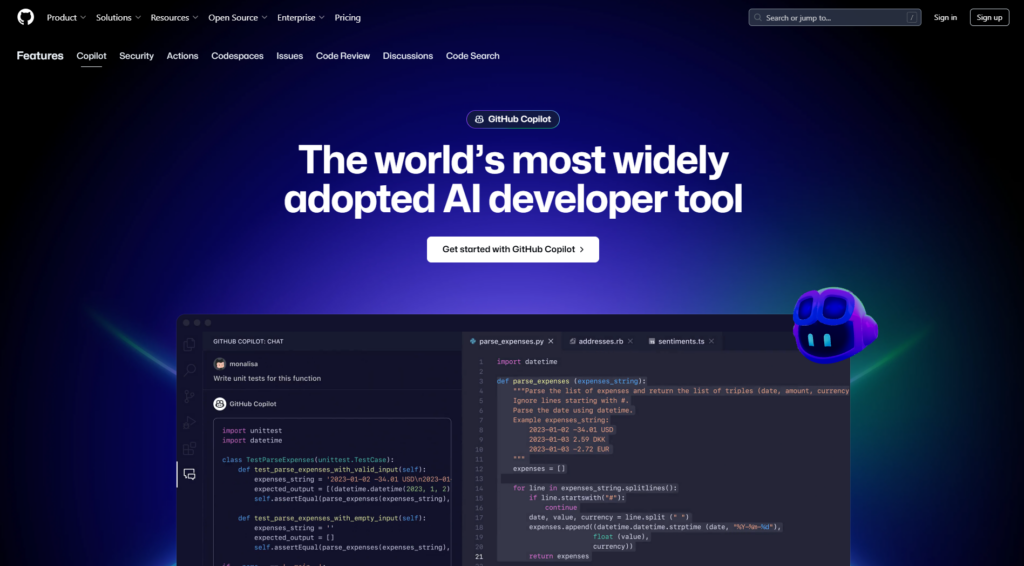

![图片[3]-LobeChat 开源项目:探索开源 AI 聊天机器人平台-|Ai Maker Hub|](https://aimakerhub.com/wp-content/uploads/2024/11/123213-1024x712.png)

六、总结

LobeChat 是一款功能强大的开源 AI 聊天框架,为开发者提供了灵活的工具和高自由度的自定义能力。无论是想快速搭建一个聊天机器人应用,还是研究 AI 技术的可能性,LobeChat 都是一个值得尝试的选择。

关键词:LobeChat 开源、AI 聊天框架、多模型支持、模块化聊天机器人

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容